Страх перед штучним інтелектом давно вкорінився в масовій культурі. Кращі уми людства, від Стівена Гокінга до Ілона Маска, говорили про екзистенційну загрозу людству від цифрового розуму.

Професор Каліфорнійського університету в Берклі Стюарт Рассел теж про неї говорить, але в його баченні майбутнього немає злих роботів, які повстають проти панування людей.

За версією Рассела, машини в якийсь момент просто стануть настільки ефективними, що знищать нас, виконуючи завдання, яке ми їм дали.

Пан Рассел – експерт з машинного навчання і автор книги “Сумісність з людиною: штучний інтелект і проблема контролю” (“Human Compatible: AI and the Problem of Control”).

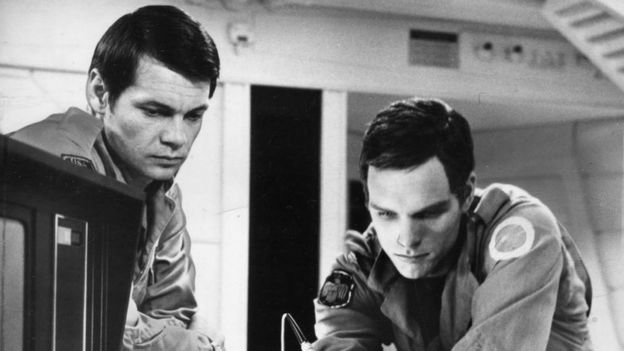

“Традиційний голлівудський сюжет: машини спонтанним чином набувають свідомість, а потім вирішують, що ненавидять людей і захочуть всіх убити”, – зауважує професор Рассел.

Але це, на його думку, неправильне бачення робоапокаліпсиса, адже у машин немає людських емоцій.

“Нам потрібно турбуватися не про свідомість злих машин, а про компетентність машин, які виконують поставлені нами завдання”, – переконаний вчений.

“Занадто компетентні”

В інтерв’ю програмі BBC Today професор Рассел описав гіпотетичну ситуацію, в якій існуванню людства може загрожувати штучний інтелект.

Уявіть, що існує надпотужний штучний інтелект, який може контролювати клімат на планеті. Йому ставлять завдання повернути рівень вуглекислого газу в атмосфері на доіндустріальний рівень.

“Система вважатиме, що найефективніший спосіб це зробити – знищити людей. Це ж вони виробляють вуглекислий газ”, – каже професор.

“Це можна обійти, наприклад, поставивши їй умову не позбуватися від людей. Що тоді зробить система? Вона буде робити так, щоб народжувалося все менше і менше дітей, поки люди не зникнуть зовсім”.

Це приклад того, до чого може привести робота штучного інтелекту згідно з непродуманими інструкціями людини.

Надрозум

Актуальні на сьогодні системи штучного інтелекту мають вузьке застосування. Вони створені для вирішення чітко визначених проблем в якійсь одній сфері, кажуть вчені Центру вивчення екзистенційних ризиків університету в Кембриджі.

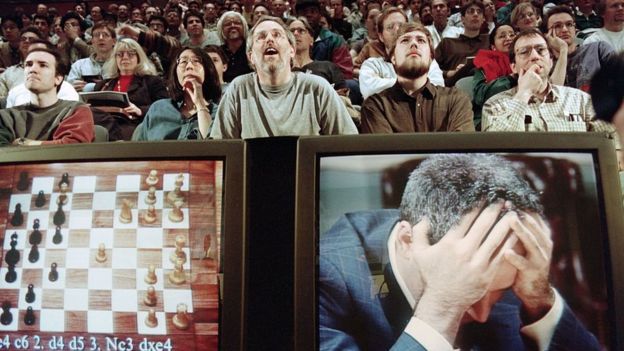

Тріумфальним моментом для цієї філософії штучного інтелекту була перемога комп’ютера “Діп Блю” над чинним чемпіоном світу з шахів Гаррі Каспаровим у 1997 році.

Але “Діп Блю” був створений виключно для гри в шахи. В шашки він програв би й п’ятикласникові.

Останні досягнення у сфері штучного інтелекту дозволили створити зовсім інші програми.

Наприклад, програма AlphaGo Zero навчилася грі в го самостійно, не використовуючи дані про минулі ігри, в які грали люди, і лише за три дні гри з собою вийшла на недосяжний для звичайної людини рівень.

Під час створення AlphaGo Zero застосували алгоритми глибинного навчання. Це означає, що для розробки програми було потрібно небагато людської роботи.

При цьому AlphaGo Zero вміє добре грати і в шахи, і в сьогі.

Нагадаємо, що програма повністю здатна для самостійного навчання. У когось це може викликати побоювання.

“З плином часу, коли штучний інтелект стає більш потужним і універсальним, з’являється ризик, що він стане надрозумним, тобто перевищить людину в багатьох або у всіх сферах”, – говорять в Центрі вивчення екзистенційних ризиків.

“Ми не знаємо, чого хочемо”

Професор Рассел вважає, що просто ставити перед штучним інтелектом конкретні завдання – це не вихід, тому що люди самі не можуть їх досить добре формулювати.

“Ми не розуміємо, що нам щось не подобається, поки цього не відбувається”, – говорить він.

“Нам потрібно змінити сам базовий підхід до створення систем штучного інтелекту”, – додає професор. Він вважає, що давати роботам завдання, які вони потім виконують – взагалі неправильне рішення.

“Система має розуміти, що мета їй незрозуміла. – говорить він. – Коли створюються такі системи, вони дійсно залежать від людини. Вони починають питати дозволу перед тим, як щось зробити, тому що не впевнені, чи хочете ви цього”.

І найважливіше, каже професор, вони не будуть чинити опір, якщо ви вирішите їх вимкнути, тому що вони створені таким чином, щоб не робити того, що вам не подобається.

Лампа Аладдіна

Штучний інтелект сьогодні створюють так, ніби це джин з лампи, говорить професор Рассел. Ви трете лампу і говорите: “Хочу, щоб відбулося це або це”.

І якщо штучний інтелект досить потужний, то він зробить саме те, що ви попросите.

“Проблема з джином в тому, що третє бажання завжди – скасувати два перших, тому що людина неправильно їх сформулювала”.

“Машина, яка ставить собі невірну мету, стає де-факто ворогом людства, і цей ворог значно сильніший за нас”, – підсумовує вчений.